Регрессия Деминга - Deming regression

В статистика, Регрессия Деминга, названный в честь У. Эдвардс Деминг, является модель ошибок в переменных который пытается найти линия наилучшего соответствия для двумерного набора данных. Он отличается от простая линейная регрессия в этом он составляет ошибки в наблюдениях как по Икс- и у- ось. Это частный случай Всего наименьших квадратов, что позволяет использовать любое количество предикторов и более сложную структуру ошибок.

Регрессия Деминга эквивалентна максимальная вероятность оценка модель ошибок в переменных в котором ошибки для двух переменных считаются независимыми и нормально распределенный, а отношение их дисперсий, обозначенное δ, известен.[1] На практике это соотношение можно оценить из соответствующих источников данных; однако процедура регрессии не учитывает возможные ошибки при оценке этого отношения.

Регрессия Деминга лишь немного сложнее вычислить по сравнению с простая линейная регрессия. Большинство пакетов статистических программ, используемых в клинической химии, предлагают регрессию Деминга.

Первоначально модель была представлена Адкок (1878) кто рассматривал дело δ = 1, а затем в более общем виде Куммелл (1879) с произвольным δ. Однако их идеи оставались практически незамеченными более 50 лет, пока не были возрождены Купманс (1937) а позже размножился еще больше Деминг (1943). Последняя книга стала настолько популярной в клиническая химия и связанные поля, которые даже назвали метод Регрессия Деминга в этих областях.[2]

Технические характеристики

Предположим, что имеющиеся данные (уя, Икся) являются измеренными наблюдениями за "истинными" значениями (уя*, Икся*), лежащие на линии регрессии:

где ошибки ε и η независимы, и предполагается, что отношение их дисперсий известно:

На практике дисперсии и параметры часто неизвестны, что затрудняет оценку . Обратите внимание, что когда метод измерения для и то же самое, эти отклонения, вероятно, будут равны, поэтому для этого случая.

Мы стремимся найти линейку «наиболее подходящих»

таким образом, чтобы взвешенная сумма квадратов остатков модели была минимизирована:[3]

См. Дженсен (2007)[4] для полного вывода.

Решение

Решение может быть выражено через выборочные моменты второй степени. То есть сначала рассчитываем следующие величины (все суммы идут от я = От 1 до п):

Наконец, оценки параметров модели методом наименьших квадратов будут[5]

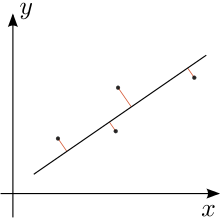

Ортогональная регрессия

Для случая равных дисперсий ошибок, т. Е. Когда , Регрессия Деминга становится ортогональная регрессия: минимизирует сумму квадратов перпендикулярные расстояния от точек данных до линии регрессии. В этом случае обозначим каждое наблюдение как точку zj в комплексной плоскости (т. е. точка (Иксj, уj) записывается как zj = Иксj + иуj куда я это мнимая единица ). Обозначим как Z сумма квадратов разностей точек данных от центроид (также обозначается в комплексных координатах) - это точка, горизонтальное и вертикальное положение которой являются средними значениями точек данных. Потом:[6]

- Если Z = 0, то каждая линия, проходящая через центр тяжести, является линией наилучшего ортогонального соответствия [это неверно - возьмите прямоугольник с центром в начале координат, представляющий четыре точки данных и выровненный по горизонтальной и вертикальной осям. Если ширина больше высоты, то лучше подходит ось x, чем ось y].

- Если Z 0, ортогональная линия регрессии проходит через центроид и параллельна вектору от начала координат до .

А тригонометрический представление ортогональной линии регрессии было дано Кулиджем в 1913 г.[7]

Заявление

В случае трех неколлинеарный точки на плоскости, треугольник с этими точками в качестве вершины имеет уникальный Штайнер инеллипс это касается сторон треугольника в их серединах. В большая ось этого эллипса попадает на ортогональную линию регрессии для трех вершин.[8]

Смотрите также

Примечания

Рекомендации

- Адкок, Р. Дж. (1878). «Проблема наименьших квадратов». Аналитик. Анналы математики. 5 (2): 53–54. Дои:10.2307/2635758. JSTOR 2635758.CS1 maint: ref = harv (связь)

- Кулидж, Дж. Л. (1913). «Два геометрических приложения математики наименьших квадратов». В Американский математический ежемесячный журнал. 20 (6): 187–190. Дои:10.2307/2973072.CS1 maint: ref = harv (связь)

- Cornbleet, P.J .; Гохман, Н. (1979). «Неверные коэффициенты регрессии методом наименьших квадратов». Clin. Chem. 25 (3): 432–438. PMID 262186.CS1 maint: ref = harv (связь)

- Деминг, В. Э. (1943). Статистическая корректировка данных. Wiley, NY (издание Dover Publications, 1985). ISBN 0-486-64685-8.CS1 maint: ref = harv (связь)

- Фуллер, Уэйн А. (1987). Модели ошибок измерения. John Wiley & Sons, Inc. ISBN 0-471-86187-1.CS1 maint: ref = harv (связь)

- Глэйстер, П. (2001). «Снова о наименьших квадратах». Математический вестник. 85: 104–107. Дои:10.2307/3620485.CS1 maint: ref = harv (связь)

- Дженсен, Андерс Кристиан (2007). «Регрессия Деминга, пакет MethComp» (PDF).CS1 maint: ref = harv (связь)

- Купманс, Т. К. (1937). Линейный регрессионный анализ экономических временных рядов. ДеЭрвен Ф. Бон, Харлем, Нидерланды.CS1 maint: ref = harv (связь)

- Куммелл, К. Х. (1879). «Редукция уравнений наблюдения, которые содержат более одной наблюдаемой величины». Аналитик. Анналы математики. 6 (4): 97–105. Дои:10.2307/2635646. JSTOR 2635646.CS1 maint: ref = harv (связь)

- Линнет, К. (1993). «Оценка регрессионных процедур для сравнительных исследований методов». Клиническая химия. 39 (3): 424–432. PMID 8448852.CS1 maint: ref = harv (связь)

- Минда, Д.; Фелпс, С. (2008). «Треугольники, эллипсы и кубические многочлены» (PDF). Американский математический ежемесячный журнал. 115 (8): 679–689. МИСТЕР 2456092.CS1 maint: ref = harv (связь)[постоянная мертвая ссылка ]